Mayflower Labs

Wo Enterprise-KI entsteht

Unsere R&D-Projekte werden nicht in Schubladen verstaut. Sie lösen echte Kundenprobleme und fließen direkt in produktionsreife Lösungen ein.

Wie wir arbeiten

- Von Kundenproblemen zu Prototypen

Wir widmen uns von Anfang an realen Herausforderungen aus der Praxis. Daraus entwickeln wir Prototypen in unserer R&D-Zeit, die wir dann direkt bei Kunden zum Einsatz bringen können.

- Open Source first

Auditierbar, erweiterbar und unabhängig von Vendor Lock-ins.

- Produktionsreif in Wochen

Von der Idee zum funktionierenden System – nicht in Monaten, sondern in 4-6 Wochen.

- Jedes Experiment mit Business Case

Keine Forschung ohne konkreten Kundennutzen und messbaren Impact.

Unsere Labs-Projekte

Wähle dein Thema

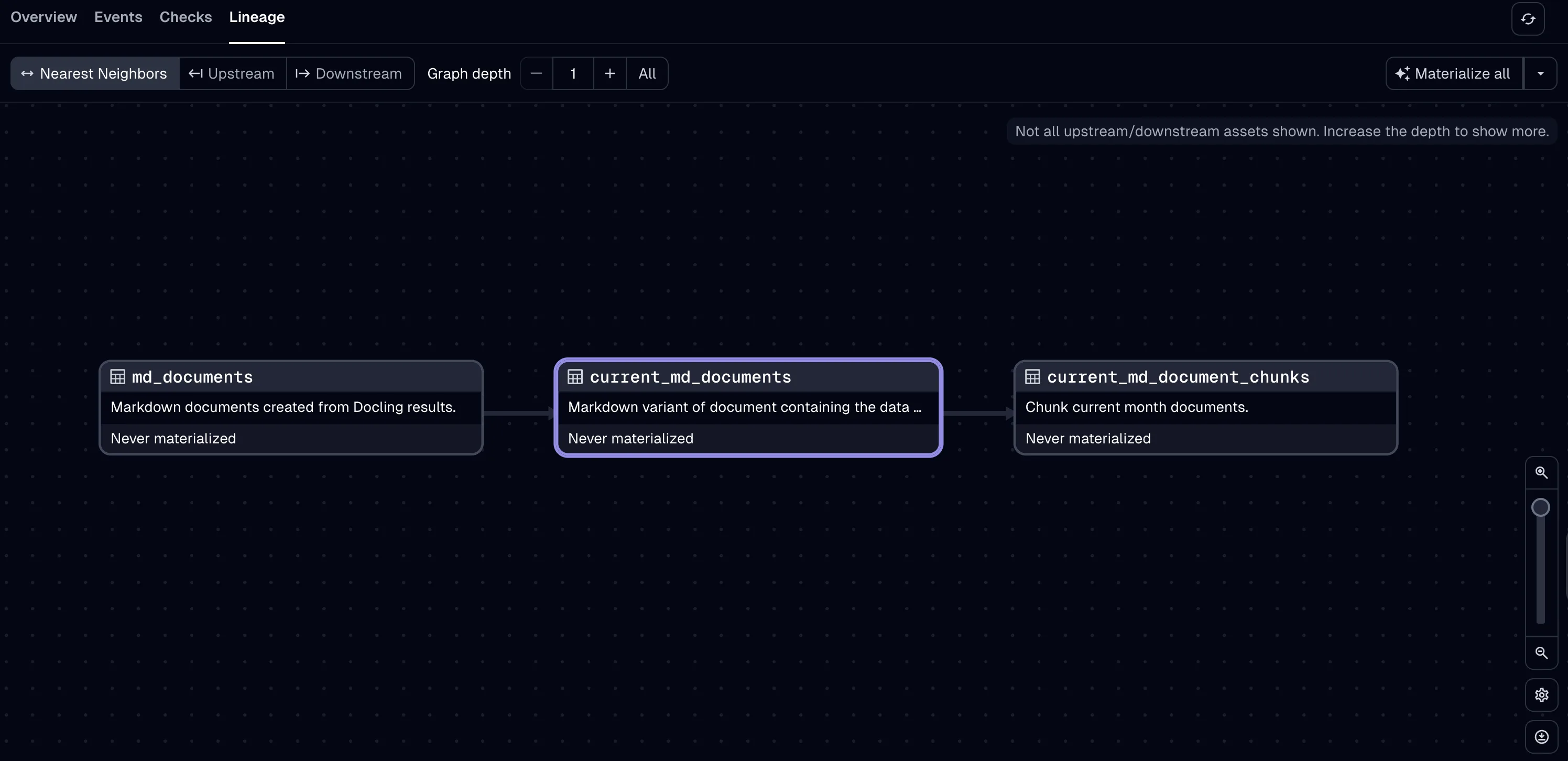

AI-Powered Data Pipelines

Von Rohdaten zu kontextreichem Wissen

Was ist das?

Automatisierte ETL/ELT-Pipelines, die Daten aus hunderten Quellen (SharePoint, Mail, CRM/ERP-Systeme u.v.m.) extrahieren, mit AI transformieren und in einem Graph-RAG für KI-Workloads bereitstellen. AI interpretiert dabei Videos, Excel-Formeln, Bilder in PDFs und PowerPoints – semantische Wissensgenerierung statt bloßer Datenextraktion.

Impact für dich

- Hunderte Datenquellen automatisch erschließbar (SharePoint, Mail, CRM, ERP)

- AI-gestützte Anreicherung: Videos, Excel, Bilder systematisch interpretiert

- Graph-RAG statt klassisches RAG – semantische Zusammenhänge erkennbar

- MCP-Integration: Wissen für alle Agenten-Systeme verfügbar

- Dagster

- Graph-RAG

- MCP

- Docling

- Multimodal AI

- 100+ Connectors

Produktionsreif – Teil von mAIstack

Datensilos aufbrechen?

Lass uns besprechen, wie wir deine verteilten Datenquellen intelligent erschließen und für KI nutzbar machen.

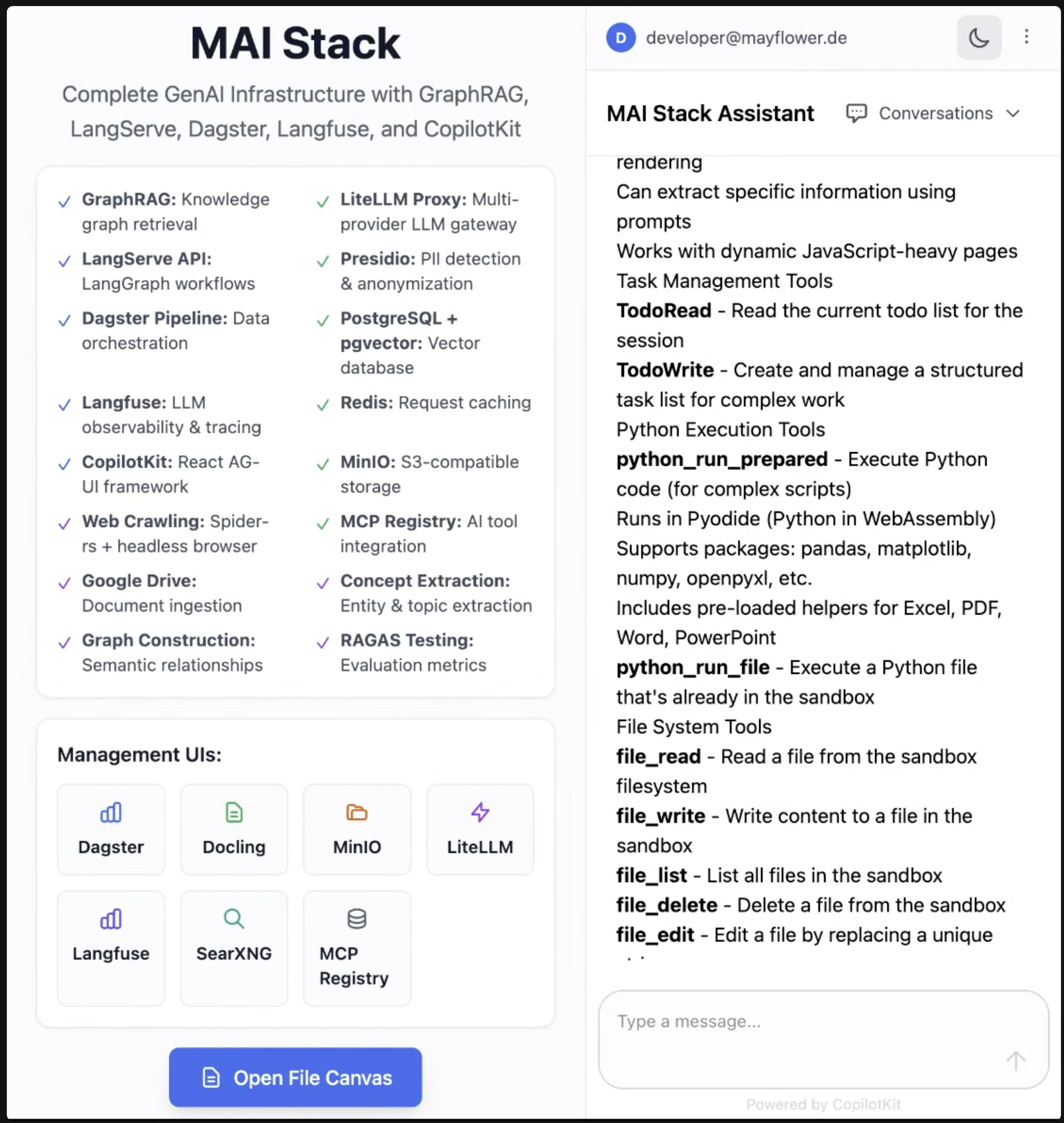

mAIstack

Enterprise-KI in Wochen – Von Idee zu Produktion

Was ist das?

Universeller Basis-Stack für agentische AI-Projekte mit Self-healing Datapipelines, dynamischer Code-Generierung (Skills), Multimodal-RAG, A2A, UI-Kit für Agents und Canvas. Die Software-Umsetzung unserer empfohlenen unternehmensweiten Open-Source-AI-Architektur.

Impact für dich

- Time-to-Market: 4-6 Wochen statt 6-12 Monate

- Self-Healing Data-Pipelines reduzieren Ops-Aufwand um 70 Prozent

- Skills mit dynamischer Programmcode-Generierung (wie Claude Skills)

- Multimodal-RAG, Agent-to-Agent, Canvas und UI-Kit inklusive

- LiteLLM

- Langfuse

- Dagster

- Qdrant

- MCP

Produktionsreif

Projekte schneller starten?

Zeige uns deine KI-Idee – wir schätzen ein, wie mAIstack deinen Start beschleunigt.

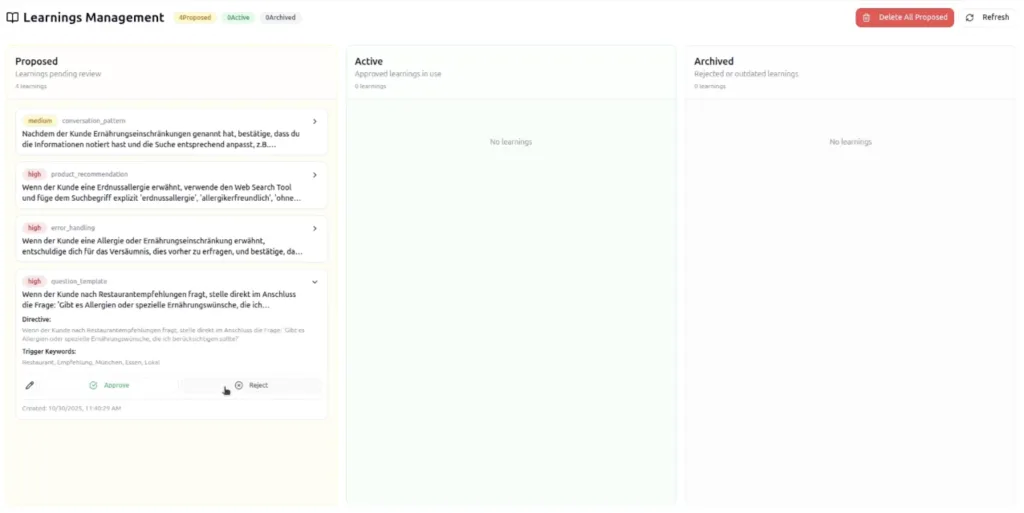

Meta-Learning Agent

Self-Learning & Self-Correction ohne Retraining

Was ist das?

Eine Komponente, die Agenten automatisches Lernen ermöglicht. Learnings werden inkorporiert, Fehler werden nicht wiederholt. Self-Learning und Self-Correction mit Human-in-the-Loop Supervised Learning.

Impact für dich

- Fehlerrate sinkt automatisch um 40-60% nach ersten Wochen

- Keine manuellen Updates bei wiederkehrenden Edge Cases

- Human-in-the-Loop für kontrolliertes Lernen

- Reduziert Maintenance-Aufwand langfristig drastisch

- Reinforcement Learning

- Langfuse

- Vector Store

- HITL

Beta – Integration in mAIstack geplant

Dein Agent soll automatisch lernen?

Wir zeigen dir, wie Meta-Learning in deinem Szenario funktioniert.

3D-Avatar VoiceAI

Human-centered Voice Interaction

Was ist das?

Vollständig animierte 3D-Avatare für stationäre Kiosk-Lösungen, die natürlich mit Kunden interagieren. Der 3D-Avatar ist ein Teil unserer VoiceAI-Basislösung. Ausführliche Informationen findest du auf Realtime-VoiceAI.

Impact für dich

- Reduktion der Hemmschwelle bei Self-Service-Terminals um 60 Prozent

- Einsatz in Filialen, Messen, öffentlichen Einrichtungen

- Mehrsprachig und Barrierefrei

- Realtime S2S

- Lip-Sync

- Emotion Rendering

- WebRTC

In Kundenprojekt (Fashion Retail)

Avatar-Lösung für deine Filiale?

Lass uns deinen Use Case besprechen – unverbindlich, 30 Minuten.

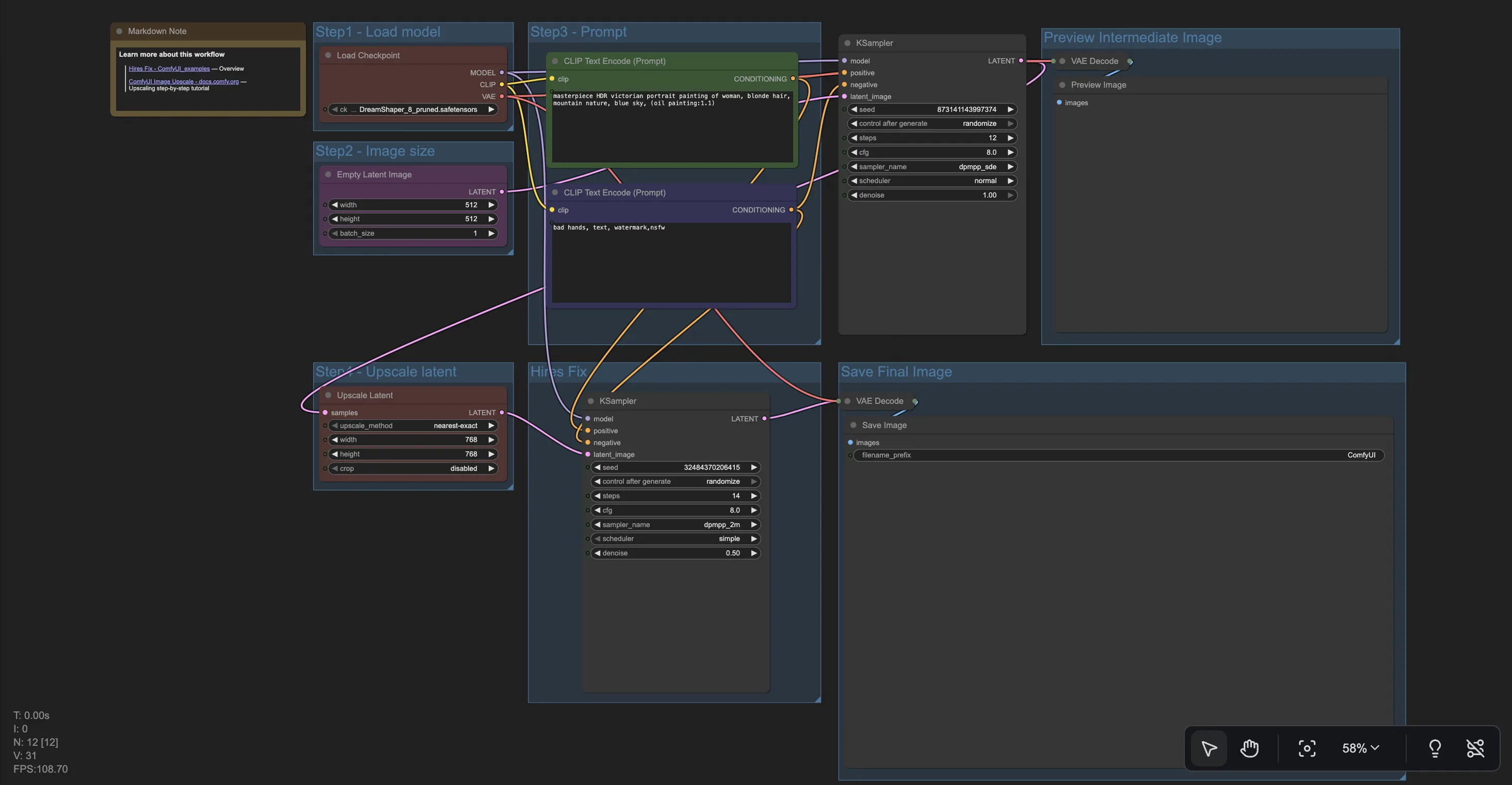

AI Fashion Shooting Pipeline

Virtual Try-On ohne physische Shootings

Was ist das?

Bildgenerierungs- und Modifikations-Pipelines mit lokaler Highend-GPU. Speziell für den Ersatz von Fashion-Shootings entwickelt – inklusive Virtual Try-On Technologie. Die AI Image Pipeline ist auch für andere Use Cases und Branchen einsetzbar.

Impact für dich

- 80-90 % Kostenreduktion bei Fashion-Shootings

- Von 6 Wochen auf 2 Tage Time-to-Market

- Unbegrenzte Varianten (Farben, Models, Hintergründe)

- Lokale GPU = 100 Prozent DSGVO-konform

- Stable Diffusion

- ControlNet

- ComfyUI

- Local GPU

In Kundenprojekt pilotiert

Fashion oder Product Shooting?

Lass uns durchrechnen, wie viel Zeit und Budget du mit AI-Pipelines sparst.

Sensitive Voice Transcription

DSGVO-konforme Transkription für sensible Branchen

Was ist das?

Automatisierte Voice-Transkription für hochsensible Daten (Anwälte, Kliniken) mit lokaler Verarbeitung und Custom Training für Fachbegriffe. Die Zeiten einfacher Transkription sind vorbei – aus den enthaltenen Informationen werden direkt weitere Workflows und Aufträge angestoßen, durch agentische Systeme in unserer Basis-Architektur.

Impact für dich

- 100 Prozent DSGVO-konform durch lokale Verarbeitung

- Custom-Training für Fachbegriffe (Medizin, Jura)

- Agentische Workflows: Aus Transkripten werden automatisch Aufträge generiert

- 95%+ Genauigkeit bei Fachtermini

- Whisper

- Agentic Workflows

- Local Training

- Presidio

Pilotprojekt

Sensible Daten transkribieren?

Wir besprechen deine Compliance-Anforderungen und zeigen dir die Architektur.

Und noch mehr …

Neben unseren Hauptprojekten entwickeln wir kontinuierlich weitere Tools und Komponenten – von MCP-Servern bis hin zu spezialisierten Embedding-Modellen. So sind im Lab auch diese Sachen entstanden:

Erweiterte Vision-Language-Model-Unterstützung für hochpräzise Dokumentenverarbeitung

SmolLM German Embeddings

Optimierte deutsche RAG-Performance mit spezialisiertem Small Language Model

VNC-Use

Computer-Use als MCP für VNC-Verbindungen – kompatibel mit Gemini und Claude

AI-Caramba

Automatische Code-Dokumentation mit Kontext-Verständnis und Semantic Analysis

Gemini Music

Kommandozeilen-Tool zur AI-gestützten Musikanalyse und Pattern-Recognition

LangChain TreeSitter

LangChain-Adapter auf TreeSitter für agentische Code-Analyse

Spring Migrator

Automatische Modernisierung von Spring MVC zu Spring Boot mit Best Practices

Konvertiert Excel zu LibreOffice, inklusive aller Formeln. VBA-Code wird nach Python übersetzt

Von Labs zu Production

Wie dein Projekt von unserem R&D profitiert

Komponenten wiederverwenden

Alles, was in Labs entsteht, ist modular und sofort in Kundenprojekten einsetzbar. Du profitierst von Battle-Tested Code.

Schnellerer Start

mAIstack gibt dir einen 6-Wochen-Vorsprung – inklusive Best Practices aus echten Projekten und bewährten Architekturen.

Continuous Innovation

Neue Features fließen automatisch in bestehende Projekte ein – du profitierst vom gesamten Labs-Output.

Unser Open-Source-Ökosystem

- LiteLLM

- Langfuse

- Docling

- Dagster

- Qdrant

- GuardRails

- Presidio

- n8n

- LangChain

- MCP

- vLLM

- Hugging Face

Bereit für Innovation?

Lass uns deinen Use Case besprechen – ob du eine konkrete Herausforderung hast oder einfach explorieren willst, was möglich ist.